Chapitre 2 Questions de biophysique et de technologie

Premières définitions

Réglages

Quels réglages de l’échographe modifient l’échelle visuelle des gris, c’est-à-dire l’intensité des blancs et des noirs ?

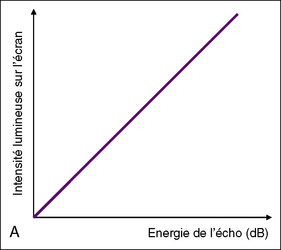

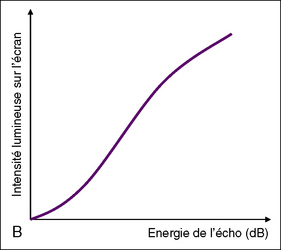

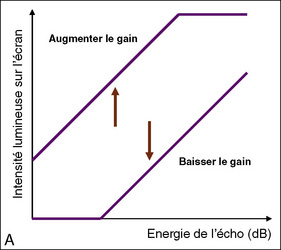

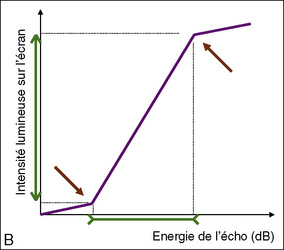

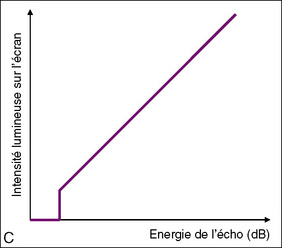

Ces réglages doivent être adaptés à chaque patiente (figure 2.2A, B, C) :

• contraste et brillance du moniteur ;

• gain (post traitement) et réglage TGC (Time Gain Compensation : la dizaine de petits curseurs qui se déplacent parallèlement les uns aux autres et qui permettent de modifier le gain à chaque étage de l’image) ;

• puissance acoustique, ou énergie d’émission ;

• contraste ou dynamique (compression de l’échelle) ;

• courbe gamma (rend compte de la courbe générale de l’intensité des points en fonction de l’amplitude des échos ; il n’est pas conseillé d’y toucher) ;

• reject ou filtre (il supprime les faibles échos, c’est-à-dire ceux ayant peu d’énergie).

Quels réglages de l’échographe modifient la cadence image en imagerie B ?

• profondeur : quand elle augmente, la CI diminue ;

• largeur de la fenêtre : quand elle augmente, la CI diminue ;

• zoom (à l’écriture) : quand il augmente, la CI augmente ;

• tirs croisés (compound) : quand il est activé, la CI diminue ;

• densité de ligne (ou Beam process) : quand elle augmente, la CI diminue ;

• focales : plus elles sont nombreuses plus la CI diminue ;

• doppler couleur : plus la fenêtre est grande plus la CI est faible ;

Ne jouent pas sur la cadence image :

Comment j’explique la formation d’un point sur une image – localisation et intensité du blanc

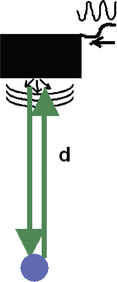

Un point sur l’écran (ou pixel) représente un écho de l’ultrason émis (on parle d’onde incidente et d’onde réfléchie). Il se forme quand il rencontre une interface entre deux éléments de propriétés mécaniques différentes. Son énergie est proportionnelle à la différence d’impédance. Quand les deux structures sont très différentes (par exemple muscle-os), l’énergie (ou amplitude) de l’onde réfléchie est forte ; quand la différence d’impédance est petite, l’énergie de l’onde réfléchie est faible (l’unité de l’énergie acoustique est le décibel : dB). L’énergie de l’onde réfléchie se traduit sur l’écran par l’intensité du blanc (Brightness, luminosité, en mode B). Le point est positionné sur l’écran par la simple mesure du temps t entre l’émission et la réception. En effet, D = c.t ; la distance entre la sonde représentée par le haut de l’image et le point étudié est la mesure d. La distance d doit être parcourue deux fois : aller (d) + retour (d) ; D = 2d ; c = la vitesse moyenne des ultrasons dans le corps humain (1 540 m/s). Chaque ligne étant construite l’une après l’autre, l’image se forme grâce à la succession de lignes (figure 2.3).

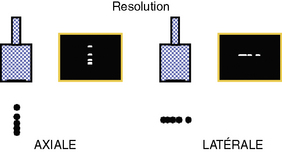

Comment j’explique les différences entre les résolutions spatiales et la résolution de contraste

La résolution spatiale est la plus petite distance entre deux points que l’échographe est capable de différencier. En dessous de cette limite biophysique, les deux points apparaîtront comme un seul. La résolution axiale (dans le sens des ultrasons, c’est-à-dire verticale) est meilleure (donc plus petite) que la résolution latérale (perpendiculaire à la précédente, ou horizontale) (figure 2.4).

Comment j’explique et j’illustre les limites de la résolution axiale en faisant appel aux connaissances sur la longueur d’onde

La résolution axiale est limitée par la longueur de l’onde λ. Celle-ci se calcule comme suit :

Où c = 1 540 m/s ; c’est la vitesse moyenne des ultrasons dans le corps humain, et f la fréquence de la sonde en MHz.

Ainsi, λ = 1 540 000 (mm/s)/6 000 000 (Hz) pour une sonde de 6 MHz.

C’est-à-dire λ = 1,5/6 (en mm) = 0,25 mm.

De façon simple, λ (mm) = 1,5/fr ; fr étant la fréquence de la sonde exprimée en MHz.

Pour aller plus loin

Comment j’explique l’atténuation de la pixellisation par anticrénelage et son inconvénient sur les toutes petites mesures

Sur la ligne A figurant une mesure de clarté nucale, les flèches sont positionnées sur la marche d’escalier entre le blanc et le noir. La limite est nette. Sur la ligne B qui a subi le traitement par anticrénelage, la partie blanche apparaît plus large, l’image est plus agréable, mais la mesure de la clarté nucale est diminuée (figure 2.5).

Stay updated, free articles. Join our Telegram channel

Full access? Get Clinical Tree