Chapitre 1 Modalités radiologiques

Radiologie conventionnelle ou classique

Découverts par Wilhelm Conrad Röntgen il y a plus d’un siècle (encadré 1.1), les rayons X sont encore largement utilisés en imagerie médicale diagnostique. Ils font partie des rayonnements ionisants. C’est leur utilisation qui est exploitée en tomodensitométrie. En radiologie conventionnelle, la radiographie « simple » reste un examen très fréquemment réalisé, notamment en pathologie pulmonaire et ostéo-articulaire. La radiographie du thorax est l’examen le plus pratiqué en France et dans le monde.

Encadré 1.1 La découverte des rayons X

En 1894, Wilhelm Conrad Röntgen est un physicien dont la réputation est déjà largement établie. C’est à partir de cette année-là qu’il décide d’orienter ses recherches sur la décharge des courants haute tension dans les gaz raréfiés et les rayons cathodiques. Il se servait alors du tube de Crookes pour étudier les effets du passage d’un faisceau électronique dans les gaz rares. Pour analyser ce faisceau électronique ou cathodique fluorescent, il se servait d’un tube en verre où régnait un vide non parfait, puis de l’interaction des ions arrachés de la cathode qui se trouvaient attirés par une plaque métallique de charge positive. Les constituants d’un tube à rayons X étaient en fait ici rassemblés.

Les rayons X étaient dès lors prêts à passer à la postérité et à engendrer de multiples progrès dans les domaines scientifiques et technologiques, en médecine bien sûr, mais également en physique et en chimie.

Production des rayons X

Une fois produits par le chauffage du filament, les électrons sont attirés vers la cible (l’anode) par une différence de potentiel très élevée qui peut varier de 40 à 150 kilovolts. Plus la différence de potentiel est élevée, plus l’accélération est grande et plus l’énergie cinétique des électrons lors du choc est importante. Ainsi, plus la différence de potentiel est élevée et plus les rayons X sont énergétiques. On parle de rayons X à basse tension, de 40 à 90 kilovolts et à haute tension de 100 à 150 kilovolts.

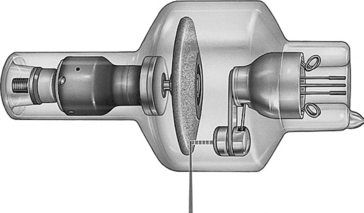

Le trajet des électrons entre la cathode émettrice et l’anode réceptrice se fait au sein d’une enceinte qui a pour objectif de maintenir un vide. L’enceinte doit être insensible aux très hautes températures créées par l’émission de rayons X et radiotransparente. Le tube ainsi constitué d’une cathode, source des électrons, et d’une anode, cible des électrons, soumis à une différence de potentiel élevée entre cathode et anode au sein d’une enceinte sous vide, est lui-même inclus dans une gaine plombée pourvue d’une ouverture, ou fenêtre de sortie, placée en face de l’anode qui permet l’émission du faisceau de rayons X (fig. 1.1). Cette émission de faisceau de rayons X s’effectue à travers un filtre qui permet d’éliminer les photons de trop faible énergie, puis au travers de diaphragmes et de localisateurs qui permettent de déterminer plus précisément les dimensions et la forme du champ d’irradiation. On peut encore limiter et préciser le champ d’irradiation par l’addition de cônes localisateurs qui permettent d’adapter parfaitement le faisceau de rayons X aux dimensions de la région anatomique à examiner.

Propriétés des rayons X

La fidélité se rapporte aux règles d’optique radiologique qui peuvent être à l’origine d’un agrandissement ou d’une déformation géométrique de la structure étudiée. Par exemple, la radiographie thoracique est réalisée en plaçant la face antérieure du sujet contre la cassette et le tube à rayons X à distance pour éviter un trop fort agrandissement de la silhouette cardiaque : on parle d’incidence postéro-antérieure. À l’inverse, quand on réalise une radiographie du thorax au lit du malade parce qu’il est trop fatigué, on glisse la cassette sous le malade. L’incidence est donc antéropostérieure et la silhouette cardiaque artificiellement agrandie ne peut être correctement interprétée. C’est l’exemple le plus caractéristique de déformation géométrique.

Le contraste qualifie la différence de densité optique entre deux régions voisines de l’image radiologique. C’est lui qui permet sur une image radiologique de différencier deux structures de densités différentes. En radiologie classique, le contraste n’est pas très marqué.

La définition caractérise la netteté de l’image. Comme en photographie, une image est nette lorsqu’on a minimisé l’ensemble des sources de flou ; ce peut être un flou géométrique (déformation de la structure étudiée), un flou cinétique (déplacement pendant l’exposition), un flou diffusé, lié à la présence de rayonnement X diffusé secondaire émis par l’objet radiographié.

L’utilisation en radiologie conventionnelle du tube à rayons X vise à obtenir une image optimale. On peut ainsi régler la différence de potentiel, tension d’accélération des électrons mesurée en kilovolts qui détermine l’énergie et le pouvoir de pénétration des rayons X. À haute tension, les rayons X sont plus pénétrants mais le contraste diminue. À basse tension, les rayons X sont moins pénétrants, mais le contraste augmente. Parallèlement, on peut régler l’intensité du filament en milliampères et le temps de pose en secondes. On comprend facilement que la dose délivrée et donc le noircissement dépendent de la quantité de photons produits par unité de temps et du temps de pose. Parallèlement, on cherche à diminuer le rayonnement diffusé par l’utilisation de diaphragme, de localisateur et de grille antidiffusante. On vise à amoindrir la déformation de l’image en fonction des caractéristiques géométriques de l’installation et on gère l’agrandissement de l’image.

Détection de l’image radiante

En technologie analogique, on se sert de la technique très ancienne (du début du XXe siècle) du couple écran/film. Il s’agit effectivement d’associer à un film sensible, tout à fait comparable au film photographique, un écran renforçateur permettant d’améliorer la sensibilité du système. Lorsque le rayonnement X atteint les cristaux de bromure d’argent contenus dans l’émulsion du film, il se forme une image qui, une fois développée comme tout autre film photographique, apparaît sous la forme d’une échelle de nuances lumineuses allant par niveaux de gris du blanc au noir. Les zones du film atteintes par le rayonnement X apparaissent en noir. Au contraire, les zones moins facilement traversées par les rayonnements X, comme les os, apparaissent en blanc. On parle ainsi de zones radiotransparentes qui apparaissent en noir, facilement traversées par les rayons X, et au contraire de zones radio-opaques qui apparaissent en blanc, lorsqu’une structure a plus nettement arrêté les rayons X.

En technologie numérique, il existe plusieurs systèmes de détection des rayons X. L’amplificateur de luminance permet des acquisitions statiques (image figée) mais aussi une procédure radiologique dynamique, par exemple la progression d’un produit de contraste ingéré au sein de l’œsophage et de l’estomac.

Les écrans radioluminescents à mémoire, encore appelés plaques photostimulables, représentent la version numérique du couple écran/film conventionnel. Comme le couple écran/film conventionnel, ils se présentent sous la forme de cassettes contenant les informations sous une forme numérique.

L’un des principaux avantages de cette numérisation de l’image tient à ce qu’elle donne accès à des techniques simples de traitement permettant de modifier et d’améliorer le rendu final. On peut, par exemple, en modifiant la largeur et le niveau de la fenêtre de visualisation, modifier le contraste et la luminosité d’une image. On peut encore réaliser des filtrages afin d’améliorer le contraste ou la résolution spatiale. Il est également possible d’utiliser des outils simples permettant des mesures de distance ou d’angle qui peuvent être utilisées en pratique orthopédique notamment. Cette numérisation bouleverse aussi complètement le système d’archivage et de diffusion des images qui se fait maintenant par l’intermédiaire de systèmes d’archivage et de communication numérique (PACS, picture archiving and communication system), autorisant la conservation sous un format inaliénable de l’ensemble des documents radiologiques du patient.

Formation de l’image radiographique

L’image radiographique correspond donc à la projection sur un plan à deux dimensions du faisceau de rayons X après qu’il a traversé la région anatomique examinée à trois dimensions. Ce sont donc les différentes zones d’atténuation aux rayons X qui déterminent l’image, cette atténuation étant en rapport avec l’épaisseur et la densité des différentes régions traversées. Ainsi, l’image radiographique n’est qu’une représentation planaire de tout un volume, un peu comme l’ombre projetée au sol d’un volume exposé par le soleil. Il existe en quelque sorte une addition de l’ensemble des structures traversées par les rayons X, cette superposition intéressant toutes les structures placées entre le tube et le film. C’est la raison pour laquelle il n’est pas possible sur un seul cliché de déterminer la situation respective de plusieurs structures. Par exemple, on peut visualiser sur une radiographie du thorax de face une opacité pulmonaire, mais il n’est pas possible de savoir si le nodule est dans la région antérieure, moyenne ou postérieure du champ pulmonaire. Parallèlement, il est possible sur une radiographie du thorax de profil de voir un nodule pulmonaire, mais pas de savoir si ce nodule est situé au niveau du poumon droit ou du poumon gauche, puisque sur le cliché de profil les poumons droit et gauche se projettent au même endroit. En revanche, en comparant les résultats de la radiographie du thorax de face et de profil, on peut savoir si le nodule est situé au niveau du champ pulmonaire droit ou gauche et s’il est situé en avant, dans la partie moyenne ou la partie postérieure du poumon intéressé.

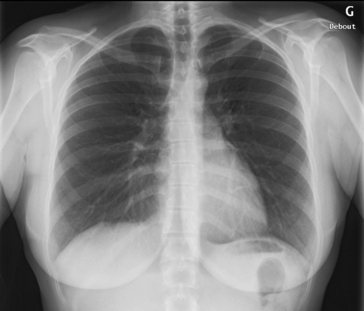

L’atténuation du faisceau de rayons X dépend de l’épaisseur du tissu traversé et de la densité du tissu traversé. En radiographie conventionnelle, il existe dans le corps humain quatre densités fondamentales (fig. 1.2) :

• la densité calcique qui caractérise l’appareil squelettique ;

• la densité hydrique qui caractérise les différents organes pleins : le foie, la rate, les reins, etc. Il n’existe pas suffisamment de différence de densité entre une tumeur du foie et le foie avoisinant pour que cette tumeur, même volumineuse, soit visualisée sur une radiographie simple. Cependant, les tumeurs calcifiées, de densité calcique, peuvent être observées. La seule exception est celle de la mammographie. Pour cela, on comprime le sein entre le foyer de rayons X et le film. On peut alors utiliser des rayons X à basse tension puisque la région à traverser n’est pas très épaisse et l’on profite aussi de la propriété de ces rayons X à basse tension qui améliore le contraste. Il est ainsi possible de repérer une lésion de la glande mammaire ;

• la densité graisseuse correspond à l’ensemble du tissu cellulaire sous-cutané et à la graisse qui entoure de nombreux organes. Elle est légèrement inférieure à la densité hydrique ;

• la densité aérique représente l’ensemble des structures qui comportent de l’air : les poumons, les sinus de la face et certaines portions du tube digestif.

Ainsi, les structures de densité calcique sont les plus denses en radiographie classique. Elles apparaissent en blanc sur le cliché. Au contraire, les structures de densité aérique sont les moins denses et apparaissent en noir sur le cliché. Les différents organes de densité hydrique apparaissent en gris et la graisse qui entoure certains d’entre eux est un peu moins dense et est représentée dans un gris un peu plus foncé (voir fig. 1.2). De plus, pour que la séparation entre deux plages de densités différentes soit visible sur un cliché radiographique, il faut que la variation de densité se fasse de façon abrupte (avec présence d’un bord). Ainsi, pour visualiser le bord entre deux structures, il faut que l’épaisseur ou la densité varient de façon brutale. C’est la raison pour laquelle sur un cliché de thorax chez la femme, l’opacité des seins est visible sous la forme d’un surcroît d’opacité (l’image est plus blanche à ce niveau). En effet, les rayons X traversent une épaisseur tissulaire plus importante à travers les seins. Mais si l’on perçoit le surcroît d’opacité, on ne peut voir la limite supérieure des seins dont le raccordement se fait en pente douce avec la paroi thoracique. Au contraire, à la partie inférieure du sein au niveau du sillon sous-mammaire, il existe une variation brutale d’épaisseur entre le sein et la paroi thoracique sous-jacente, et on visualise le bord inférieur des seins (voir fig. 1.2). Parallèlement, après une mammectomie unilatérale, il existe une différence de densité entre les deux côtés, avec une clarté du côté du sein opéré, puisque les rayons X traversent moins d’épaisseur.

Au contraire, si cette opacité est située au niveau du lobe inférieur droit qui n’est pas au contact du cœur, elle est cernée d’air et on visualise donc la limite interne de l’opacité qui n’efface pas le bord du cœur. Ce signe de la silhouette permet donc parfois de localiser une opacité. Ainsi, une pneumopathie qui se traduit par une condensation pulmonaire du lobe moyen droit efface le bord du cœur, alors qu’une pneumopathie du lobe inférieur droit n’efface pas le bord du cœur. On peut donc, sans réaliser de cliché de profil, en appliquant cette règle simple, localiser une pneumopathie développée aux dépens de la partie inférieure du poumon droit. Ainsi, en radiologie classique, on décrit les images anormales sous la forme de surcroît d’opacité ; on parle aussi d’opacité en cas d’image anormalement dense par rapport à l’environnement. On précise la densité de l’opacité en question (par exemple opacité de densité hydrique), ses dimensions, ses limites et l’éventuel effacement d’une structure de voisinage. On décrirait, par exemple pour une pneumopathie du lobe moyen droit, une opacité triangulaire, de densité hydrique, mal limitée, effaçant le bord droit du cœur.

À l’inverse, pour une image anormalement radiotransparente, trop claire, on parle d’hyperclarté. C’est par exemple sous la forme d’une hyperclarté que se traduit un pneumothorax.

Indications et limites

La radiographie classique reste largement utilisée et garde toute sa place, notamment dans les domaines des pathologies respiratoire, musculosquelettique et sénologique (mammographie). Le cliché radiographique du thorax reste l’examen de première intention, notamment pour l’exploration d’une dyspnée.

En sénologie, la mammographie reste un examen incontournable.

On rappelle pour mémoire qu’on utilisait le terme d’image d’addition lorsqu’il existait un surcroît anormal de remplissage par le produit de contraste d’une structure en dehors d’une lumière digestive. L’exemple type en est un diverticule rempli de façon anormale par le produit de contraste. À l’inverse, on parlait d’image de soustraction en cas de défaut de remplissage d’une cavité remplie par le produit de contraste, l’exemple le plus caractéristique étant un polype se traduisant sous la forme d’image de soustraction au sein de la lumière colique.

En pratique

Les rayons X ont été découverts en 1895 par Wilhelm Conrad Röntgen.

Les rayons X ont été découverts en 1895 par Wilhelm Conrad Röntgen.

Le tube, muni d’une cathode et d’une anode, permet la formation de rayons X.

Le tube, muni d’une cathode et d’une anode, permet la formation de rayons X.

L’émission de rayons X est caractérisée par la tension et l’intensité du rayon.

L’émission de rayons X est caractérisée par la tension et l’intensité du rayon.

La majorité des systèmes de détection des rayons X sont numériques.

La majorité des systèmes de détection des rayons X sont numériques.

Il existe quatre densités fondamentales : calcique, hydrique, graisseuse et aérique.

Il existe quatre densités fondamentales : calcique, hydrique, graisseuse et aérique.

Tomodensitométrie

Formation de l’image tomodensitométrique

La radiologie conventionnelle donne de la région explorée une projection plane bidimensionnelle représentant la superposition de l’ensemble des structures traversées par le faisceau de rayons X. Cette superposition de l’ensemble de la projection des structures entraîne évidemment une perte d’informations très importante.

La tomodensitométrie réalise une véritable image en coupe, en utilisant un tube à rayons X et un ensemble de détecteurs qui tournent autour du sujet à examiner pour obtenir de multiples profils d’atténuation obtenus à des angles de rotation différents. Un très puissant système informatique permet de reconstruire les valeurs d’atténuation, voxel par voxel, pour obtenir une image en coupe très fine et contrastée.

Physiquement, le tomodensitomètre est donc constitué d’un ou de plusieurs tubes à rayons X, de détecteurs multiples souvent organisés en plusieurs couronnes et d’un lit d’examen qui se déplace de façon continue pendant la rotation du tube. À l’origine, le premier scanner, développé au début des années 1970, couplait un tube à rayons X à un détecteur unique et l’exploration comportait une translation puis une rotation (encadré 1.2). On a rapidement augmenté le nombre de détecteurs, puis on est passé à un système de rotation unique. Les coupes étaient alors acquises de façon itérative avec déplacements successifs du lit d’examen après chaque coupe. C’est au début des années 1990 qu’est apparue la technique de rotation continue qui permettait une amélioration considérable du temps d’acquisition, le système tubes-détecteurs tournant de façon continue, pendant le déplacement du lit. La dernière innovation a été de multiplier le nombre de détecteurs en réalisant des scanners multibarrettes, chaque barrette comportant l’ensemble des détecteurs, et donc d’acquérir simultanément autant de coupes que de barrettes. À l’heure actuelle, il existe des appareils contenant jusqu’à 320 barrettes, c’est-à-dire permettant d’obtenir 320 coupes en une seule rotation. La majorité des scanners actuels contient de 16 à 128 barrettes et permet l’exploration du corps entier en quelques secondes d’acquisition. Ces appareils permettent une acquisition volumique qui ouvre la voie aux techniques de détection automatisée par ordinateur (encadré 1.3) et de post-traitement (encadré 1.4).

Encadré 1.3 Détection automatisée par ordinateur

La détection automatisée par ordinateur, désignée souvent sous l’acronyme CAD (computed assisted detection), est une technique d’assistance à l’interprétation radiologique par l’utilisation d’un logiciel qui analyse automatiquement les images. Cette technique informatique d’assistance à l’interprétation radiologique a notamment été utilisée pour la détection de nodules pulmonaires, la détection de polypes en coloscopie virtuelle ou de lésions en dépistage mammographique.

Encadré 1.4 Post-traitement

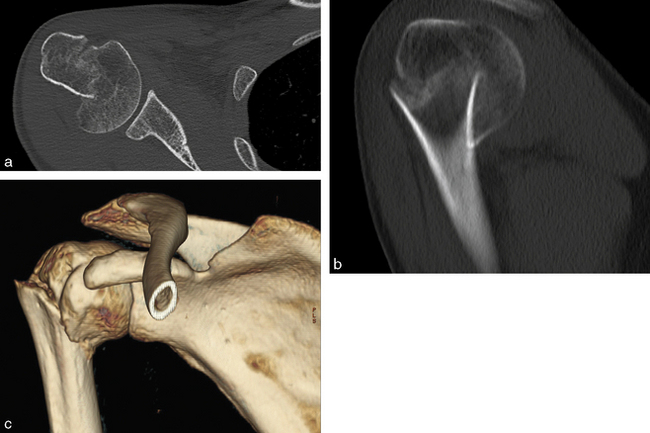

La possibilité en tomodensitométrie moderne d’obtenir des coupes très fines revient à acquérir des voxels isotropiques, c’est-à-dire ayant la même dimension dans les trois plans de l’espace (fig. 1.3a). Dans ces conditions, la porte est ouverte à de nombreuses techniques de reconstruction qui permettent de s’affranchir de la visualisation dans le plan transversal.

De multiples techniques de post-traitement peuvent être utilisées :

• reconstructions multiplanaires. La technique MPR (multiplanar reconstruction) consiste à extraire des coupes du volume dans n’importe quel plan de l’espace (fig. 1.3b). On peut obtenir ainsi facilement des coupes dans le plan frontal, dans le plan sagittal mais également dans des plans virtuels : on parle de MPR curviligne, adaptées à l’anatomie, anatomie vasculaire ou certaines pièces osseuses telle la mandibule (dental scanner) ;

• projection d’intensité maximale (maximal intensity projection, MIP). Cette technique consiste à projeter sur un même plan, selon une direction donnée, les voxels du volume qui possèdent les intensités les plus élevées. C’est une technique particulièrement utile pour étudier les vaisseaux. Elle permet de créer des images qui sont tout à fait proches de celles qu’on obtenait antérieurement en radiologie vasculaire ;

• projection d’intensité minimale (minimal intensity projection, MinIP). À l’inverse du MIP, le MinIP ne prend en compte que les voxels ayant les intensités les plus faibles. Il devient donc possible de reconstruire des structures aériques, notamment l’arbre trachéal et bronchique ;

• technique de rendu de volume (volume rendering technique, VRT). La technique de rendu de volume permet d’obtenir des images 3D extrêmement fidèles dans des fenêtrages variés. Par exemple, il est possible de reconstruire avec une excellente fidélité anatomique les pièces osseuses (fig. 1.3c) ;

• endoscopie virtuelle. Il s’agit ici de développer une technique de navigation qui peut être appliquée au sein de structures contenant de l’air, comme le côlon et les bronches. Elle peut se développer également au sein de structures vasculaires. Par exemple, pour l’analyse du côlon, on peut en coloscopie virtuelle obtenir des analyses très proches de celles obtenues en coloscopie conventionnelle.

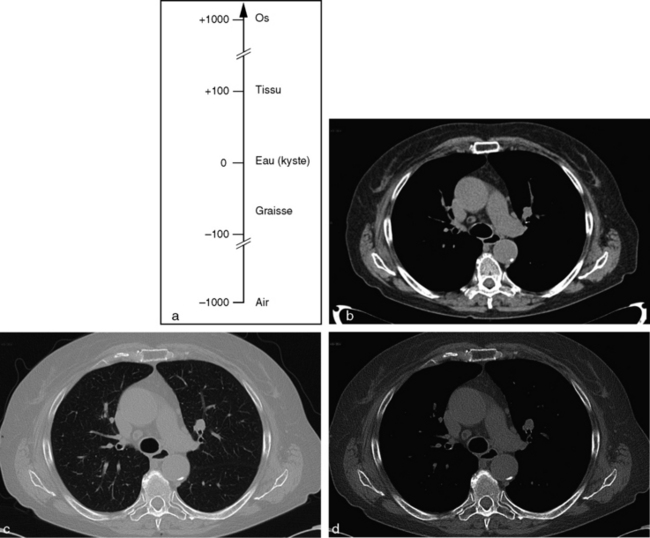

Plus récemment encore sont arrivés des scanners mode biénergie permettant l’acquisition de deux images, à deux tensions différentes. À partir de ces images natives, on peut reconstruire une image virtuelle correspondant à une tension quelconque du tube à rayons X, ouvrant la voie à des caractérisations tissulaires plus aisées. Il est alors possible, à l’aide d’ordinateurs très puissants, de calculer la densité élémentaire (on devrait parler de coefficient d’atténuation) de chaque pixel de la matrice. En fonction de sa densité, chaque pixel est représenté sur l’image par une certaine valeur dans l’échelle des gris. L’échelle de Hounsfield classe les tissus en tenant compte de leur coefficient d’atténuation (densité) dont la limite inférieure est de –1 000 UH (unités Hounsfield), ce qui correspond à l’air, et la limite supérieure à 1 000 UH ou plus, ce qui correspond à la corticale osseuse. Ainsi, les structures peu denses, comme le parenchyme pulmonaire, se situent dans la partie négative de l’échelle (–400 à –800 UH), et la plupart des parenchymes (foie, rate, cerveau) ont des valeurs qui varient entre 20 et 100 UH. Les tissus graisseux ont une densité négative de l’ordre de –50 à –100 UH. Les structures denses (os et calcification) ont des densités élevées, de plusieurs centaines à plusieurs milliers d’unités Hounsfield. Ainsi, l’échelle de Hounsfield peut être composée de plusieurs milliers d’unités correspondant à plusieurs milliers de niveaux de gris différents (fig. 1.4a). Malheureusement, l’œil humain n’est capable de distinguer qu’une vingtaine de niveaux de gris. Autrement dit, si l’échelle de gris était répartie sur l’ensemble de l’échelle de Hounsfield, les tissus mous et notamment les lésions développées au sein d’organes pleins ne seraient pas discernés par l’œil par manque de contraste. C’est la raison pour laquelle en scanner on n’attribue l’échelle de gris qu’à une portion spécifique de l’échelle de Hounsfield afin de pouvoir étudier les tissus souhaités. Ce processus d’analyse des images est appelé fenêtrage. Le fenêtrage permet d’attribuer l’ensemble de la gamme des niveaux de gris à la région d’intérêt. Une fenêtre d’examen est déterminée par son niveau, qui définit le centre de la fenêtre, et par sa largeur, qui détermine l’ensemble des structures de densités différentes que l’on peut étudier. On le voit sur la coupe sous forme de lettres figurant au bas de l’image : « C » pour centre et « L » pour largeur (ou « C » pour center et « W » pour width). On distingue trois grandes variétés de fenêtrage :

• les fenêtres tissulaires sont relativement spécifiques des tissus des organes pleins (fig. 1.4b). Leur niveau est adapté au niveau moyen des parenchymes solides, proche de 0, et leur largeur est restreinte : on parle de fenêtre étroite ou serrée, afin de pouvoir mettre en évidence au sein d’un parenchyme plein de petites différences de densité. En revanche, tout ce qui est en dessous de la limite inférieure de la fenêtre apparaît en noir et tout ce qui est au-dessus de la limite supérieure de la fenêtre apparaît en blanc ;

• les fenêtres pulmonaires ont un niveau bas qui se situe dans la portion négative de l’échelle de Hounsfield pour s’adapter à l’étude des structures parenchymateuses pulmonaires, et une largeur étendue pour pouvoir étudier les bronches jusqu’aux alvéoles (fig. 1.4c). Avec cette fenêtre pulmonaire, en revanche, il n’est pas possible de mettre en évidence de petites variations de densité au sein d’un parenchyme plein ;

• les fenêtres osseuses ont un niveau relativement élevé, adapté à l’analyse du tissu osseux, et une largeur très étendue permettant d’englober l’ensemble du système, os spongieux et os compact (fig. 1.4d). Là encore, avec ces fenêtres larges, il n’est pas possible d’étudier de petites différences de densité au sein d’un parenchyme plein.

Ainsi, quand on réalise un examen tomodensitométrique du thorax, on peut être amené à l’analyser avec les trois fenêtres différentes. La première permet d’étudier finement les détails du médiastin, qui sont de densité tissulaire. La deuxième, la fenêtre pulmonaire, permet d’analyser le parenchyme pulmonaire. Et la troisième, la fenêtre osseuse, permet de chercher une lésion osseuse associée.

Critères de qualité des images tomodensitométriques

C’est la résolution spatiale qui permet de visualiser des structures de très petite taille et de discriminer des objets très proches. Elle dépend principalement de la taille du pixel et de l’épaisseur de coupe. Plus le pixel est petit et plus l’épaisseur de coupe est fine, plus la résolution spatiale à qualité d’acquisition constante est de bonne qualité.

La résolution en contraste permet de différencier deux tissus de densités différentes. La résolution en contraste peut être augmentée par le volume du voxel, mais alors on diminue la résolution spatiale, ou par l’augmentation de la dose délivrée par voxel, mais on reste limité par l’irradiation et la dose délivrée au patient.

La résolution temporelle est particulièrement importante pour les organes en mouvement et directement corrélée à la vitesse d’acquisition des images. À l’heure actuelle, la vitesse d’acquisition permet de faire disparaître les artéfacts de mouvement, sauf au niveau du cœur qui nécessite, si l’on veut l’étudier très finement, une synchronisation de l’acquisition aux battements du cœur.

C’est pourquoi en sémiologie tomodensitométrique on décrit la forme, les dimensions de l’image anormale, son homogénéité ou son hétérogénéité, et sa densité spontanée que l’on peut mesurer et exprimer en unités Hounsfield. On parle ainsi d’image hyperdense pour les images plus denses que l’environnement (c’est quelque peu un abus de langage, on devrait parler d’image hyperatténuante) ou d’image hypodense (on devrait utiliser le terme hypo-atténuante), et on décrit également l’existence d’un rehaussement au temps précoce ou au temps tardif après injection.

En matière de tomodensitométrie, la dosimétrie est un sujet de très haut intérêt. De nombreuses publications ont évoqué clairement le risque des examens tomodensitométriques en termes d’irradiation et de possible exposition à un risque carcinogène. Ainsi, l’ensemble des constructeurs ont mis au point des dispositifs de réduction de l’exposition. Très simplement, on peut utiliser des protocoles d’exploration à tension réduite (basse dose) pour les enfants et les personnes de faible corpulence. Il est aussi possible de moduler l’exposition sur l’axe z et au sein de chaque coupe, mais il est surtout logique de limiter les acquisitions et la réalisation des scanners en général, à ce qui est indispensable. L’ensemble de ces pratiques respecte le consensus ALARA (as low as reasonably achievable), autrement dit aussi bas qu’il est raisonnablement possible. C’est également la raison pour laquelle il est obligatoire de suivre la traçabilité des zones délivrées lors des examens. La dose délivrée au patient, généralement exprimée sous la forme du produit dose/longueur (PDL), doit être indiquée à la fin de chaque compte rendu.

En pratique

Les appareils actuels sont des appareils multibarrettes en rotation continue.

Les appareils actuels sont des appareils multibarrettes en rotation continue.

Les images tomodensitométriques sont analysées avec différentes fenêtres.

Les images tomodensitométriques sont analysées avec différentes fenêtres.

Les images tomodensitométriques sont caractérisées par une résolution spatiale d’excellente qualité et une résolution en contraste moins bonne.

Les images tomodensitométriques sont caractérisées par une résolution spatiale d’excellente qualité et une résolution en contraste moins bonne.

La tomodensitométrie est une technique irradiante. Il faut donc être attentif à l’exposition des patients.

La tomodensitométrie est une technique irradiante. Il faut donc être attentif à l’exposition des patients.

Échographie et Doppler

Formation de l’image échographique

L’échographie et l’effet Doppler sont des techniques d’imagerie qui exploitent le phénomène de réflexion des ondes ultrasonores. Il s’agit donc d’une technique qui ne comporte aucun des risques des explorations faites avec les rayons X puisqu’elle n’utilise pas de radiations ionisantes. D’où l’intérêt de l’échographie, notamment chez la femme enceinte, et l’utilisation progressive du terme imagerie médicale plutôt que radiologie, puisqu’à côté de techniques utilisant les rayons X (radiologie classique, tomodensitométrie), d’autres, telles que l’échographie ou l’IRM, ne font pas appel aux radiations ionisantes.

Les ondes ultrasonores à fréquence faible ont pour caractéristique de pénétrer largement pour une exploration en profondeur. Au contraire, les ondes ultrasonores à fréquence élevée ont une pénétration faible en profondeur. La réflexion de l’onde ultrasonore se produit sur l’interface acoustique, c’est-à-dire sur une frontière entre deux milieux d’impédance acoustique (d’élasticité) différente. C’est cette réflexion de l’onde ultrasonore à chaque interface qui est à la base de la formation de l’image. Cependant, il ne faut pas qu’elle soit trop importante : par exemple, au contact de l’air, il existe une réflexion de 99 % qui ne permet pas aux ultrasons de pénétrer et d’obtenir une image. C’est la raison pour laquelle on se sert, pour éviter l’interposition d’air entre la sonde échographique et le corps étudié, d’un gel échographique (correspondant à de l’eau gélifiée) qui, interposé entre la sonde et le corps, empêche une réflexion trop importante au niveau de la peau. La sonde échographique, ou transducteur, émet les ultrasons en exploitant le phénomène de piézoélectricité. On se sert effectivement de céramique piézoélectrique qui émet une onde ultrasonore très brève lorsqu’elle est soumise à une impulsion électrique. Cette sonde émettrice est également réceptrice puisqu’elle est capable d’enregistrer les échos réfléchis par le corps étudié, qui seront à leur tour transformés en une impulsion électrique à l’origine du signal. Le retour des échos à la surface de la sonde se traduit par une vibration de la céramique qui génère un signal électrique dont l’intensité est proportionnelle à celle de l’écho. C’est ce signal électrique recueilli qui participe à la formation de l’image échographique.

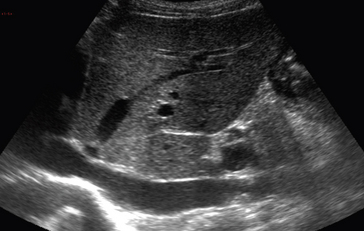

Ainsi, pour obtenir une exploration échographique de qualité, il faut d’abord déterminer la fréquence de la sonde, fréquence faible (3 à 5 MHz), pénétration suffisante pour une exploration en profondeur, ou fréquence élevée (7 à 12 MHz), exploration uniquement superficielle, mais avec une excellente résolution spatiale. Il faut également régler l’amplification globale des échos qui induit un gain de signal et l’amplification en profondeur. Effectivement, l’atténuation des échos varie avec la profondeur du tissu exploré. Plus les échos proviennent de structures profondes, moins leur intensité est élevée. C’est la raison pour laquelle il faut adapter le niveau d’amplification à chaque profondeur, c’est ce qui est fait par le réglage de la courbe de gain en profondeur. Il faut finalement éviter les interfaces caractérisées par une différence d’impédance trop importante (utilisation du gel échographique pour éviter la présence de bulles d’air entre la sonde et la peau, impossibilité d’étudier des structures directement situées derrière une composante osseuse) (fig. 1.5).

À l’heure actuelle, l’échographie est réalisée en mode temps réel, c’est-à-dire que la sonde réalise un balayage automatique et cyclique de la zone à explorer qui est définie par le plan d’exploration dépendant de la position de la sonde par rapport à la région explorée. Ces sondes électroniques qui permettent un balayage automatique en temps réel peuvent avoir des configurations différentes – barrettes, planes, courbes –, ou une configuration annulaire qui autorise des coupes à partir de l’introduction de la sonde dans une des cavités du patient. Ainsi, il est possible de réaliser des échographies par voie endovaginale, transrectale, transœsophagienne, voire intravasculaire, en introduisant de toutes petites sondes à l’intérieur des vaisseaux. Plus récemment s’est développée l’échographie tridimensionnelle permettant l’acquisition de tout un volume. On parle même aujourd’hui d’acquisition quadridimensionnelle (4D), puisqu’il est possible d’obtenir l’acquisition d’un volume en temps réel.

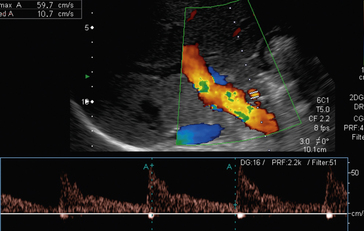

L’échographie peut être associée à l’effet Doppler qui est défini par la variation des fréquences réfléchies quand la cible rencontrée par le faisceau ultrasonore se déplace. Ainsi, la différence entre la fréquence d’émission et la fréquence de réception définit la fréquence Doppler qui, dans le cadre d’un flux sanguin, se situe dans un spectre audible. Cette fréquence Doppler est donc directement dépendante de la vitesse du flux sanguin. Cet effet Doppler peut être exploité en mode pulsé, par l’émission régulière d’impulsions ultrasonores qui sont ensuite réceptionnées et analysées sous la forme d’un spectre de vitesse. Il est également possible d’analyser le signal Doppler en transformant les variations temporelles de vitesse en fluctuations colorimétriques. On parle de Doppler couleur ; par convention, en mode Doppler couleur, les flux qui se rapprochent de la sonde sont codés en rouge et ceux qui s’en éloignent en bleu. On peut ainsi superposer cette analyse colorimétrique à l’image échographique du même plan. L’analyse Doppler couleur permet de repérer rapidement les vaisseaux circulants (fig. 1.6).

Stay updated, free articles. Join our Telegram channel

Full access? Get Clinical Tree